Google-Extended: de nieuwe Google Crawler om Bard of Google AI te blokkeren

Onlangs is er een belangrijke update geweest in het Google Search-landschap. Google heeft namelijk een nieuwe crawler toegevoegd, genaamd Google-Extended. Deze kan je gebruiken om specifieke inhoud van je website te blokkeren voor Bard, Vertex AI of andere (toekomstige) Googleproducten. Deze toevoeging is van essentieel belang voor websitebeheerders die graag controle willen hebben over hoe hun inhoud wordt gebruikt door AI-projecten van Google.

Navigeer snel naar

- Waarom is het belangrijk om controle te houden?

- Hoe werken de verschillende user-agents?

- Zo gebruik je user-agents in het robots.txt-bestand

- Update in Google documentatie voor Google-Extended

- Zo blokkeer je Bard en Vertex AI via Google-Extended

- Bescherm ook jouw website met Google-Extended

Als je interesse hebt in de ondersteuning van iClicks op dit gebied, aarzel dan niet om contact met ons op te nemen!

Waarom is het belangrijk om controle te houden?

Met de introductie van Bard en andere AI-projecten van Google, kan het wenselijk zijn om beperkte toegang te geven tot de inhoud op je website. Dankzij de nieuwe crawler is het nu mogelijk om specifiek aan te geven welke inhoud wel of niet gebruikt mag worden door dergelijke projecten. Ideaal dus!

Dit betekent dat je nog steeds kunt profiteren van het crawlen, indexeren en rangschikken door de reguliere Googlebot. Tegelijkertijd voorkom je dat Bard of andere AI-systemen toegang krijgen tot bepaalde delen van je site.

Hoe werken de verschillende user-agents?

Het belangrijkste om te weten is dat de normale crawlers, zoals de Googlebot nog steeds zullen blijven functioneren als hoe ze hiervoor deden. De toevoeging van Google-Extended betekent simpelweg dat je nu meer controle hebt over hoe jouw website-inhoud wordt gebruikt door specifieke AI-projecten.

Een woordvoerder van Google legt uit: “Google-Extended stelt ons in staat om de inhoud van een website expliciet te markeren als niet toegankelijk voor Bard en Vertex AI generatieve API’s.” Het is belangrijk om te benadrukken dat voor Search-doeleinden, websitebeheerders nog steeds de reguliere Googlebot-useragent moeten gebruiken, via het robots.txt-bestand en de metatags (bijvoorbeeld NOINDEX). Dit om de inhoud in zoekresultaten te beheren. De useragent Googlebot geldt hierbij trouwens ook voor experimenten, zoals Search Generative Experience.

Zo gebruik je user-agents in het robots.txt-bestand

Als je wilt dat alle crawlers van Google toegang hebben tot specifieke inhoud, kun je simpelweg “Googlebot” specificeren als user agent. Als je meerdere user agents hebt opgenomen in je robots.txt-bestand, volgt Google altijd de meest specifieke agent.

Wist je trouwens dat je in feite geen robots.txt-bestand nodig hebt als je wilt dat alle pagina’s op jouw website gecrawld kunnen worden door Google? Dit betekent dat al jouw pagina’s zichtbaar zullen zijn in Google Zoeken en dat AdSense-advertenties op jouw site kunnen worden weergegeven zonder een robots.txt-bestand.

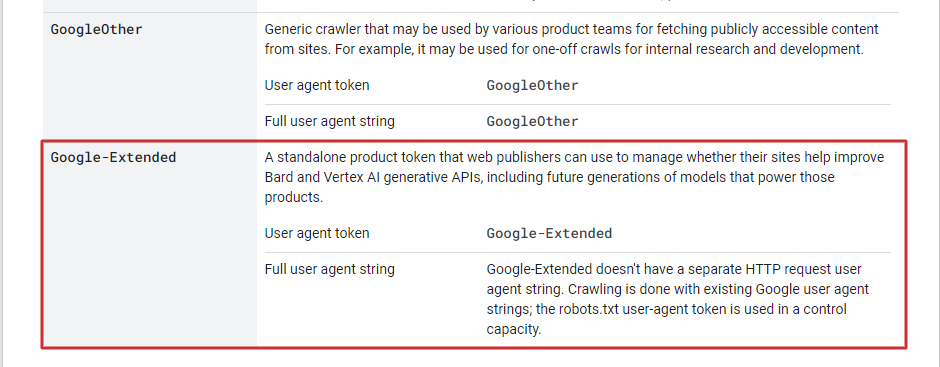

Update in Google documentatie voor Google-Extended

De uitleg om de nieuwe crawler functionaliteit toe te passen, heeft Google geüpdatet in zijn documentatie met betrekking tot crawlers. In de sectie “Google Crawler (User Agent) Overview” kun je nu gedetailleerde informatie vinden over hoe je deze nieuwe crawler kunt gebruiken om inhoud te blokkeren voor specifieke AI-projecten van Google.

Google Crawler (User Agent) Overview | Google Search Central | Documentation | Google for Developers

Zo blokkeer je Bard en Vertex AI via Google-Extended

Wil je ook voorkomen dat Bard of andere projecten, zoals Vertex AI toegang krijgen tot bepaalde delen van jouw site? Dan moet je specifieker worden en de Google-Extended user agent gebruiken in jouw robots.txt-bestand om inhoudsblokkades op te leggen. Hiermee geef je aan dat deze specifieke inhoud niet mag worden gebruikt door Bard of andere AI-projecten van Google.

Een voorbeeld:

De Googlebot heeft volledig toegang tot de website. Het gebruik van de informatie op de pagina wordt echter geblokkeerd door de regel die is toegevoegd voor de user-agent Google-Extended.

User-agent: Googlebot

Disallow:

User-agent: Google-Extended

Disallow: /

Bescherm ook jouw website met Google-Extended

Kort samengevat heeft Google met de introductie van Google-Extended een krachtige tool geïntroduceerd voor websitebeheerders. Door gebruik te maken van deze nieuwe crawler, kan je nu nauwkeurig bepalen welke inhoud wel of niet toegankelijk is voor Bard, Vertex AI en andere AI-systemen van Google. Dit geeft meer controle en bescherming aan website-eigenaren die willen bepalen hoe hun inhoud wordt gebruikt in het steeds veranderende AI-landschap.

Dus als jij een website hebt en je wilt voorkomen dat bepaalde delen ervan worden gebruikt door Bard of andere Google AI-projecten, overweeg dan zeker om de Google-Extended crawler toe te voegen aan jouw strategie voor inhoudsbeheer. Het helpt je om de controle te behouden over de grenzen van jouw online aanwezigheid en zorgt ervoor dat jouw inhoud alleen wordt gebruikt zoals jij dat wilt.